1. L0、L1、L2

x = ( x 1 , x 2 , … , x n ) T x=( x_1,x_2,…,x_n)^T x=(x1,x2,…,xn)T

1-范数:

║ x ║ 1 = │ x 1 │ + │ x 2 │ + … + │ x n │ ║x║_1=│x_1│+│x_2│+…+│x_n│ ║x║1=│x1│+│x2│+…+│xn│

2-范数:

║ x ║ 2 = ( │ x 1 │ 2 + │ x 2 │ 2 + … + │ x n │ 2 ) ║x║_2=\sqrt{(│x_1│^2+│x_2│^2+…+│x_n│^2)} ║x║2=(│x1│2+│x2│2+…+│xn│2)

L 0 L_0 L0范数是指向量中非0的元素的个数。如果我们用 L 0 L_0 L0范数来规则化一个参数矩阵 W W W的话,就是希望 W W W的大部分元素都是0。 L 1 L_1 L1范数是指向量中各个元素绝对值之和,又称“稀疏规则算子”(Lasso regularization)

L 2 L_2 L2范数在回归里面,有人把有它的回归叫“岭回归”(Ridge Regression),有人也叫它“权值衰减weight decay”。 L 2 L_2 L2范数是指向量各元素的平方和然后求平方根。让 L 2 L_2 L2范数的规则项 ∣ ∣ W ∣ ∣ 2 ||W||_2 ∣∣W∣∣2最小,可以使得 W W W的每个元素都很小,都接近于0。L 1 L_1 L1范数和 L 0 L_0 L0范数可以实现稀疏, L 1 L_1 L1因具有比 L 0 L_0 L0更好的优化求解特性而被广泛应用

2. 为什么希望模型参数具有稀疏性?

稀疏性,说白了就是模型的很多参数是0;相当于对模型进行了一次特征选择,只留下一些比较重要的特征,提高模型的泛化能力,降低过拟合的可能。3. L1正则化使模型参数具有稀疏性的原理是什么?(角度1:解空间形状)

给定数据集

D = ( x 1 , y 1 ) , ( x 2 , y 2 ) , . . . , ( x m , y m ) D={(x_1,y_1),(x_2,y_2),...,(x_m,y_m)} D=(x1,y1),(x2,y2),...,(xm,ym)

考虑线性回归模型,以平方误差为损失函数,则优化目标为

当样本特征很多,而样本数相对较少时,上式容易陷入过拟合。故引入信息正则化项缓解过拟合问题,若用 L 1 L_1 L1范数则有

若用 L 2 L_2 L2范数,则有

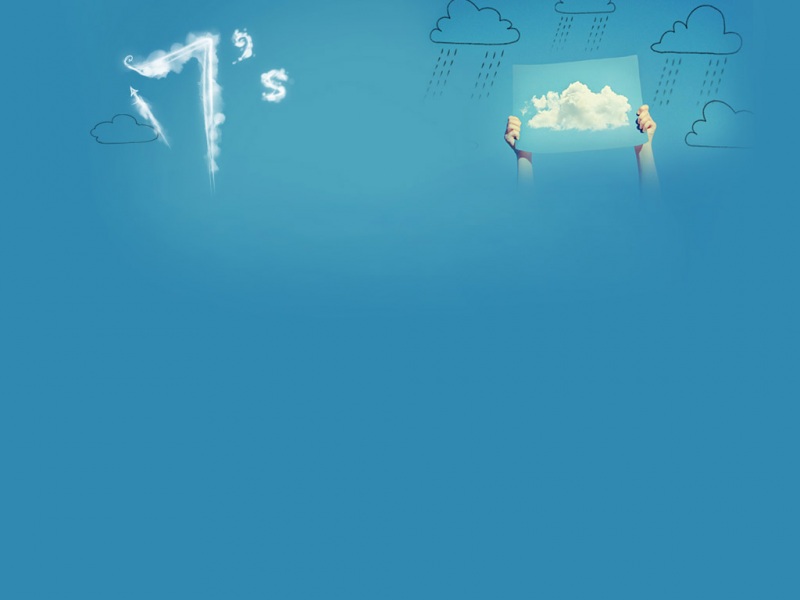

假定 x x x仅有2个属性,则无论是加入 L 1 L_1 L1还是 L 2 L_2 L2正则化解出的 w w w都只有2个分量, w 1 w_1 w1和 w 2 w_2 w2,将其作为2个坐标轴,绘制出上两式中第一项的等值线(( w 1 w_1 w1, w 2 w_2 w2)空间中平方误差项取值相同的点),再分别绘制出 L 1 L_1 L1与 L 2 L_2 L2范数的等值线,如图所示:

采用 L 1 L_1 L1范数时,平方误差项等值线和正则化项等值线的交点常出现在坐标轴上,即 w 1 w_1 w1或 w 2 w_2 w2为0,而采用 L 2 L_2 L2范数时,两者的交点常出现在某个象限中,即 w 1 w_1 w1或 w 2 w_2 w2均非0换言之,采用 L 1 L_1 L1范数比 L 2 L_2 L2范数更易于得到稀疏解基于 L 1 L_1 L1正则化的方法是一种嵌入式特征选择方法,即学习器在训练过程中自动地进行了特征选择(选择出对应于 w w w之非零分量的特征)